About Processing Data

10 Nov 2023TL;DR 데이터를 처리하고 분석하는 것을 지겨워하지 말자 (…)

One pattern I noticed is that great AI researchers are willing to manually inspect lots of data. And more than that, they build infrastructure that allows them to manually inspect data quickly. Though not glamorous, manually examining data gives valuable intuitions about the…

— Jason Wei (@_jasonwei) October 2, 2023

Translated by GPT-4 and edited by me

나는 훌륭한 인공지능 연구자들이 많은 데이터를 수작업으로 검토할 의향이 있다는 패턴을 발견했다. 그리고 그것보다 더 중요한 것은, 그들은 데이터를 수작업으로 신속하게 검토할 수 있는 인프라를 구축한다는 것이다. 화려하지 않지만, 데이터를 수작업으로 검토하는 것은 문제에 대한 귀중한 통찰력을 제공한다.

여기에 대표적인 예가 Andrej Karpathy가 스스로 ImageNet 2000가지 분류 작업을 수행했던 것이 있다. 그리고 대규모 언어 모델의 시대에는, benchmark로 모델을 평가하기 어렵기 때문에 (LLM은 정확도가 딱 떨어지는 것이 아니기 때문에), 수작업으로 데이터를 검토하는 것이 아마도 더 통찰력을 줄 수 있을 것이다.

이러한 정신으로, 최근에 나는 새로운 문제에 착수하는 것을 시작하면서 동료와 며칠 동안 pair programming을 했다. baseline을 복제하고 새로운 방법을 설계하려고 시도하기 보다는 (기존의 deep learning method들이 허구언날 public dataset에 대해 반복 실험을 하고 조금 개선해서 논문을 내는 것을 말하는 듯), 우리는 몇 가지 평가를 실행하고 수작업으로 검토하여 통찰을 얻었다.

우리는 먼저 모든 관련 정보를 한 UI에 넣는 데 하루 정도의 시간을 소비하여, 여러 웹 페이지를 클릭하지 않고도 데이터를 검토할 수 있게 했다. 둘째 날, 우리는 오후에 함께 예제를 읽고 예제에서 우리가 알아차린 패턴을 기록 하는 데 시간을 보냈다. ChatGPT는 긴 텍스트를 생성하고, 우리는 한 예제를 이해하는 데 20분이 걸릴지라도 신중하게 전체를 실제로 읽었다. 나는 우리 둘 다 논문을 읽는 것으로는 얻을 수 없었던 문제에 대한 더 깊은 이해를 얻었다고 생각한다.

(+예를 들어, 2018년에 나는 병리학자들이 폐암 분류기를 훈련시키기 위해 많은 데이터를 라벨링하는 데 도움을 주었다. 병리학자의 수정을 받으며 200개가 넘는 이미지를 수작업으로 라벨링 한 후에, 나는 그 특정한 폐암 분류 작업에서 병리학자 수준의 이해를 얻었다고 볼 수 있다)

Domain (Taks) Specific Models ?

LLM으로 모든 Modality가 통합이 되면서 많은 생각을 하게된다. 당연히 개별적인 audio, computer vision domain들에서는 task, domain specific model들이 SOTA일 것이다. 음성에서는 Conformer-Transducer, 객체인식 쪽에서는 DETR 이라던가 등등. 이런 model들은 성능면에서도 그렇지만 inference비용 면에서도 값싸기 때문에 확실히 일부 상황들에서 이득이 있을 것이다.

그런데 점점 각 mode들이 통합이 되고있다. 요즘은 LLM에 이런 vision, audio front-end들이 붙어서 작동한다. 어차피 우리가 영화 Iron Man의 Jarvis를 만든다고 치면 음성인식기가 따로 작동하고 Javis의 뇌인 LLM이 그걸 받아서 작동할 필요는 없기 때문인다. 그럼 이런 SOTA 모델들의 사용처는 어떻게 변화해야 할까? 당연히 audio, vision encoder 등은 pre-trained 된 채로 LLM에 붙어야 겠으나 개별 모델들의 task specific한 inductive bias등을 계속 가져가려고 하는것은 좋은 생각은 아닌 것 같다. 이런 SOTA모델들은 계속해서 해당 modality의 instruction data를 만드는 pseudo labeler로써의 기능만 점점 하지 않을까 싶다. 활자인식, 음성인식 그 이상의 것을 하고싶다면 그렇다는 말이다.

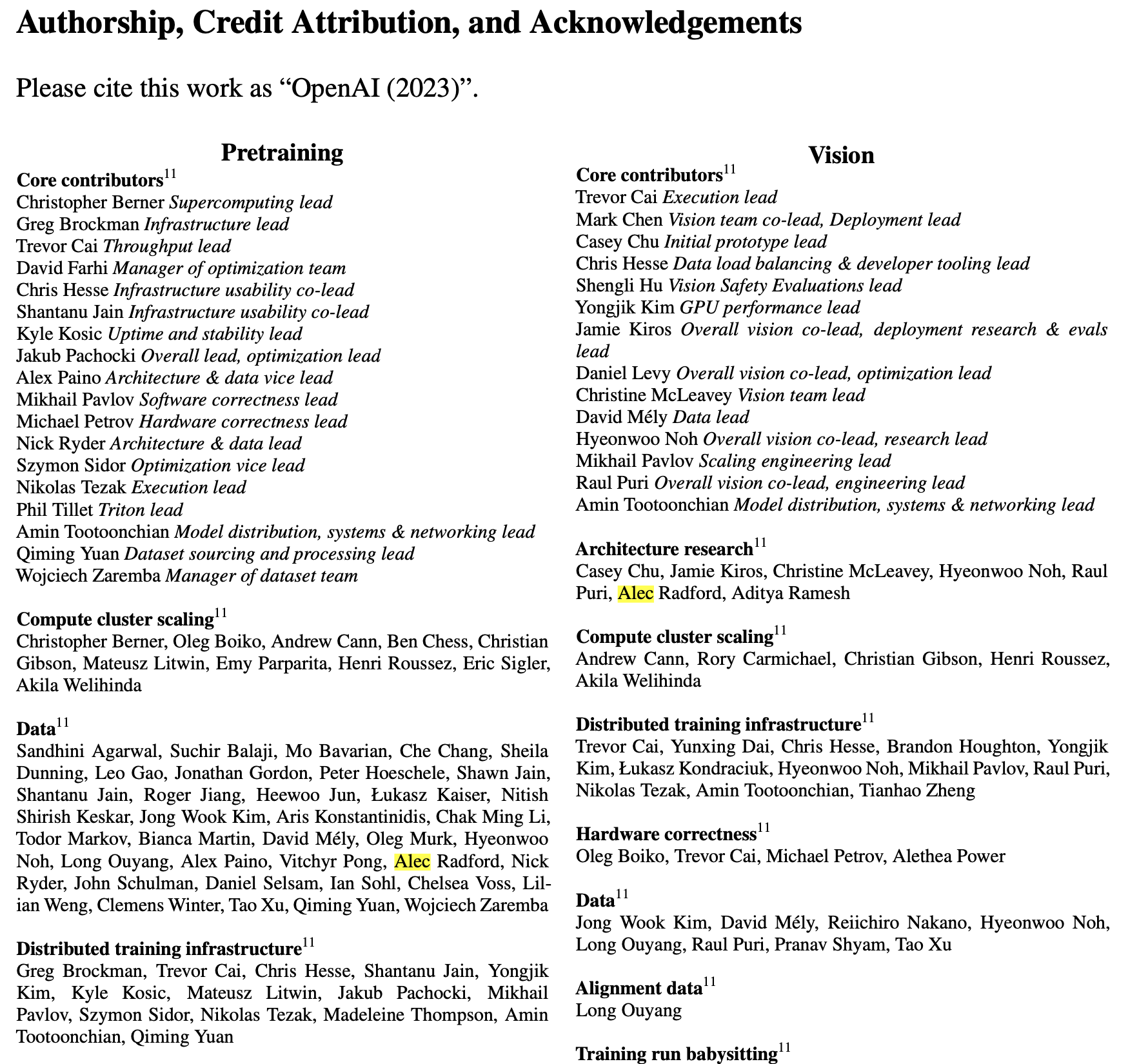

Even Alec Radford...

OpenAI의 research scientist이며 GPT series의 core contributor도 GPT-4 에는 data 부분에 많은 contribution을 한 것 같다. 그만큼 문제 정의 자체를 잘 하고 그에 맞는 data를 수집하고, 평가하는 것이 매우 중요하기 때문이 아닐까 싶다. 기존 modeling을 하던 연구자들은 그럼 어떻게 되는것인가? 자신의 전문성을 살려서 그에 맞는 instruction data, ranking data 를 만드는 것을 process화 하는 것을 잘 해야할 것 같다.

Fig.

Fig.