(WIP) (CS285) Lecture 18 - Variational Inference and Generative Models

08 Feb 2024이 글은 UC Berkeley 의 교수, Sergey Levine 의 심층 강화 학습 (Deep Reinforcement Learning) 강의인 CS285를 듣고 작성한 글 입니다.

Lecture 18의 강의 영상과 자료는 아래에서 확인하실 수 있습니다.

- Fall 2020 ver.

< 목차 >

- Overview

- Probabilistic Latent Variable Models (LVM)

- Variational Inference

- Amortized Variational Inference

- Generative models: Variational AutoEncoders (VAE)

- Reference

Overview

Slide. 1.

Slide. 1.

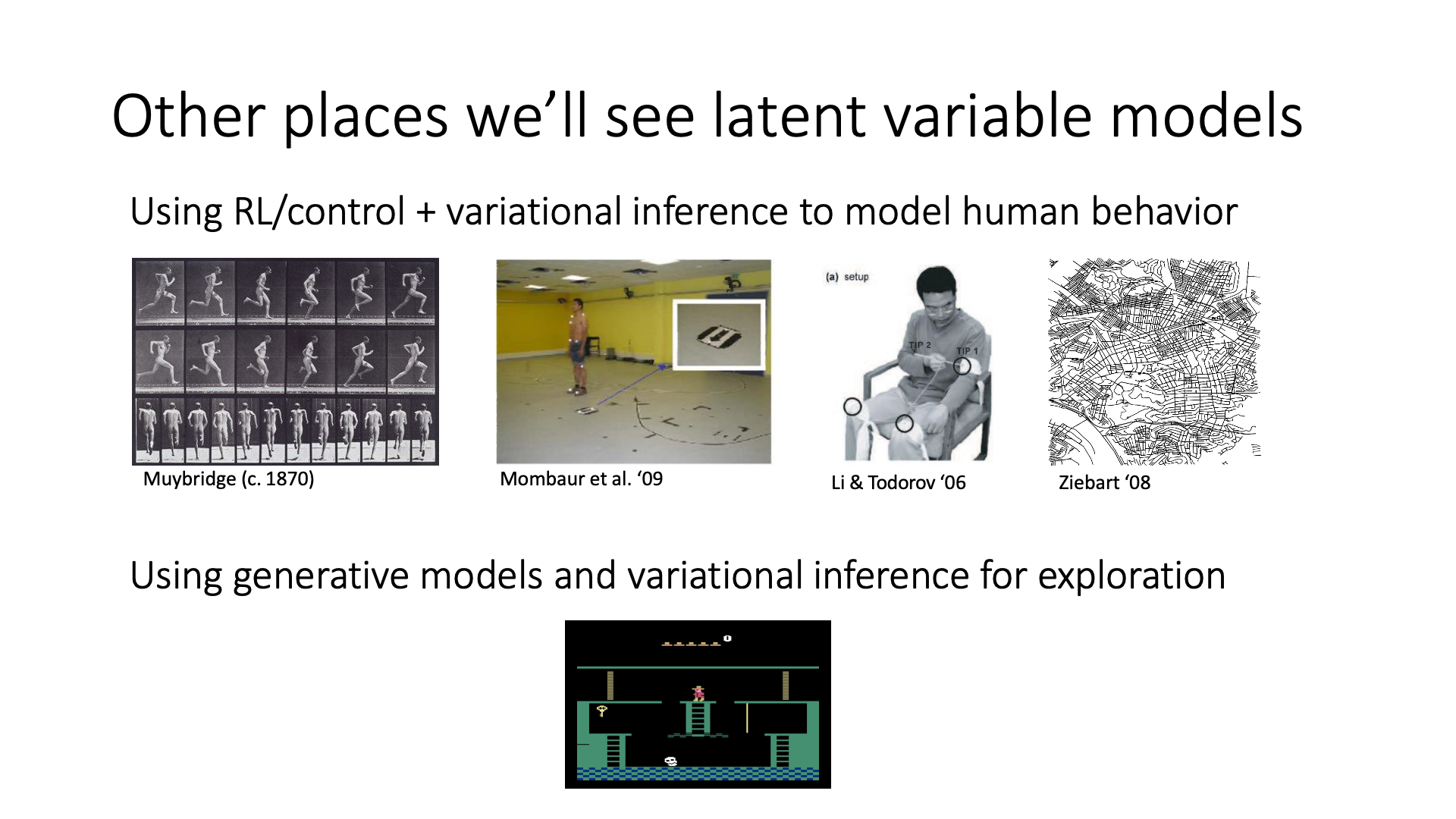

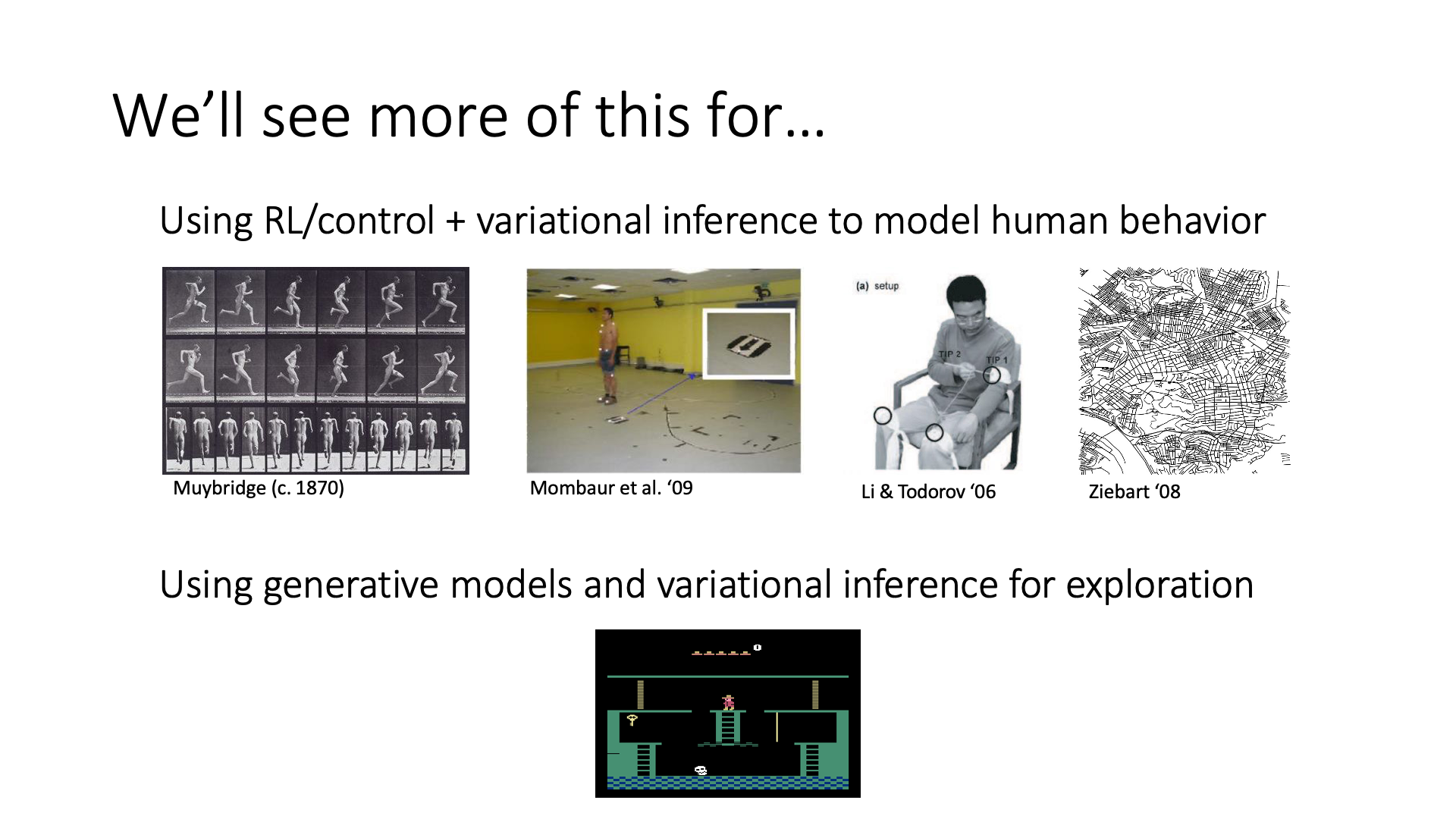

Lecture 18에서 다루게 될 내용은 새로운 RL algorithm은 아니지만 Model-Based RL, Inverse RL (IRL, 곧 배움), Exploration 등 RL의 main component들과 깊은 관련이 깊은 확률적 생성 모델 (Probabilistic Generative Models)과 변분 추론 (Variational Inference)입니다.

Slide. 2.

Slide. 2.

이번 lecture에서 다룰 주된 내용은 위 figure에 나와있는 내용과 같은데, 대충 flow가 이렇습니다.

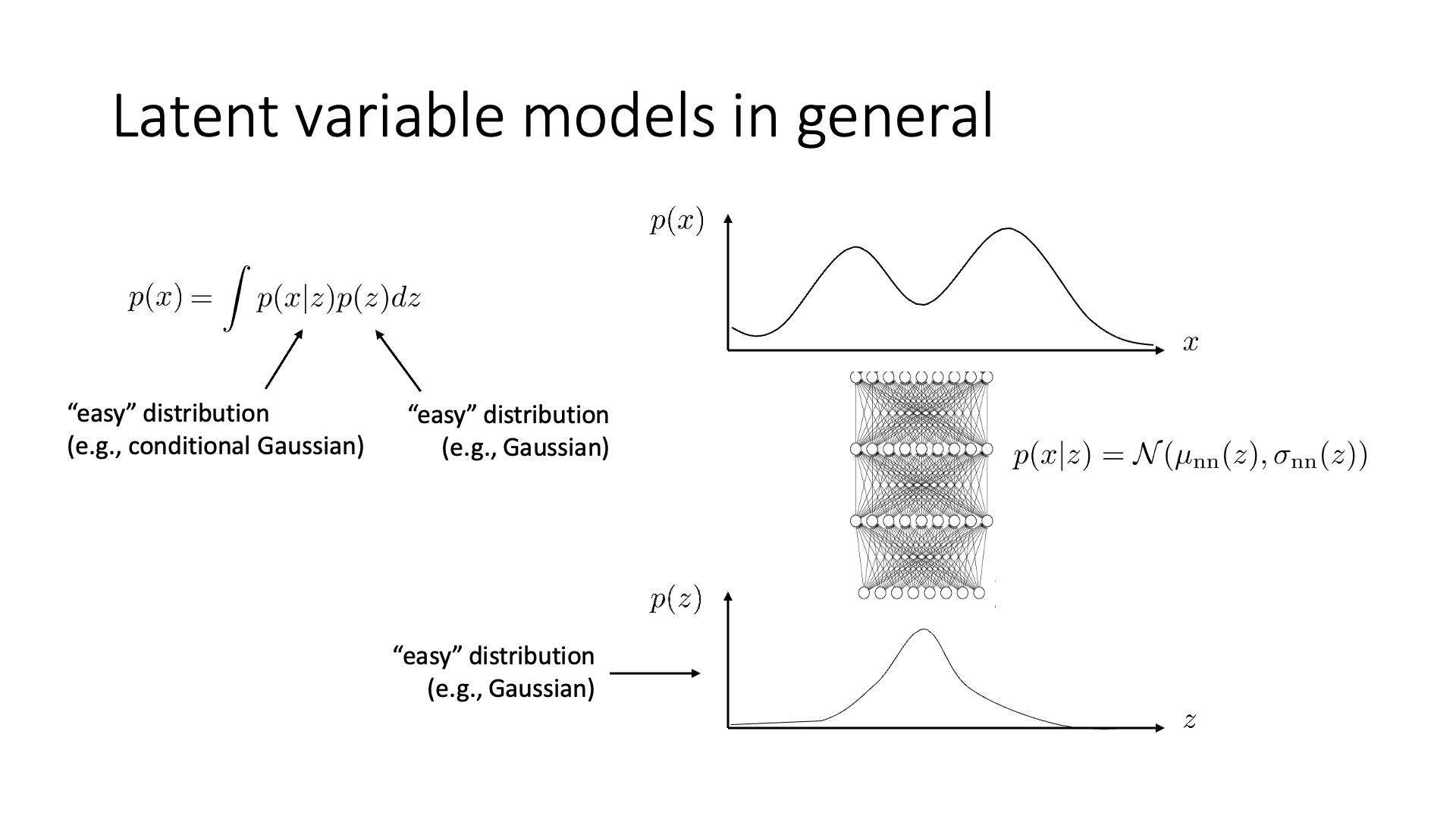

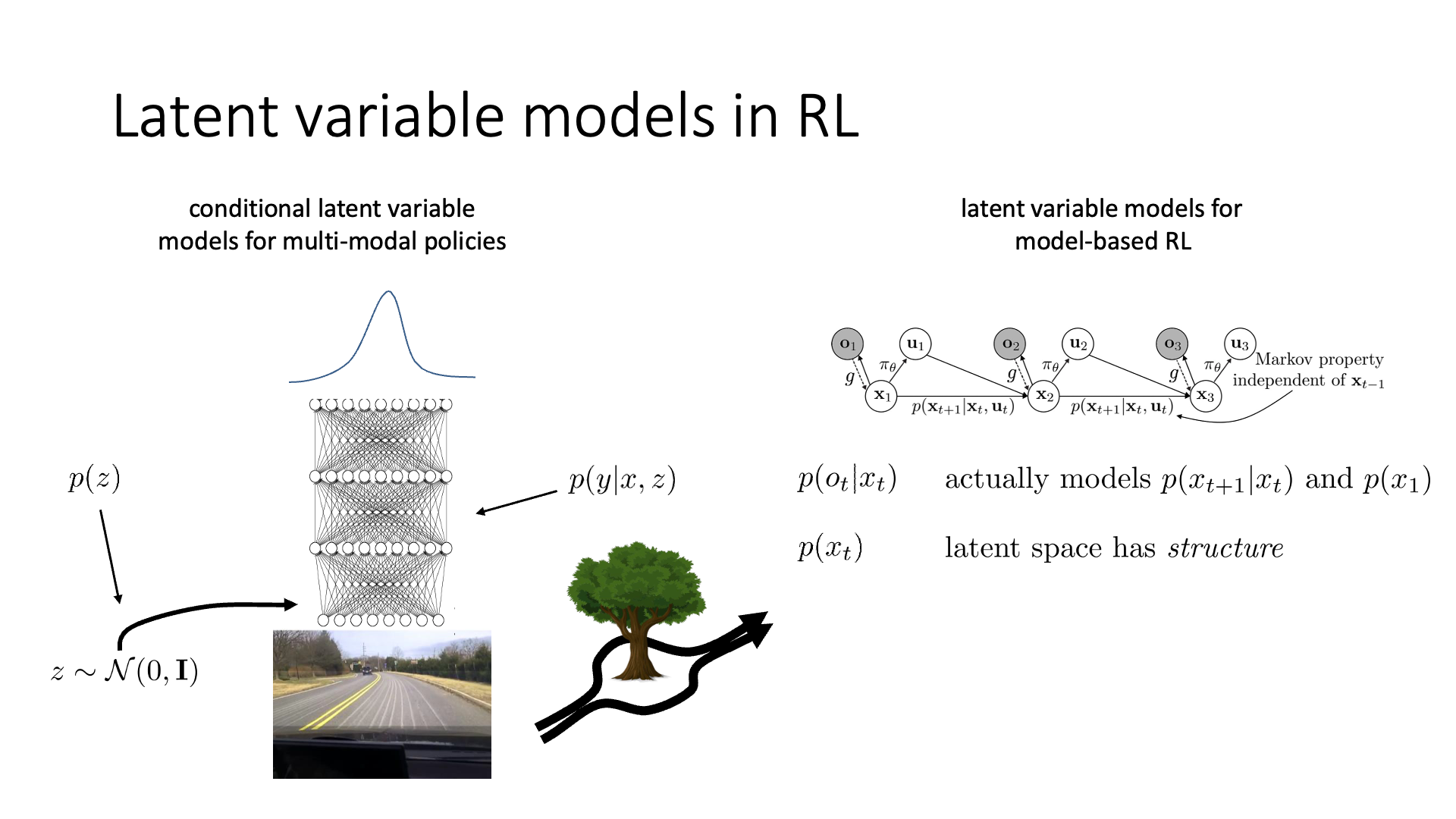

- Generative model은 보통 단봉 가우시안 분포 (unimodal guassian distribution)로 표현하기 힘들다

- 그렇다면 더 표현력이 좋은 분포 (more expressive distribution)을 정의하고 학습해야 하는데

- 여기서 사용되는 것이 잠재 변수 모델 (Latent Variable Model; LVM)이다.

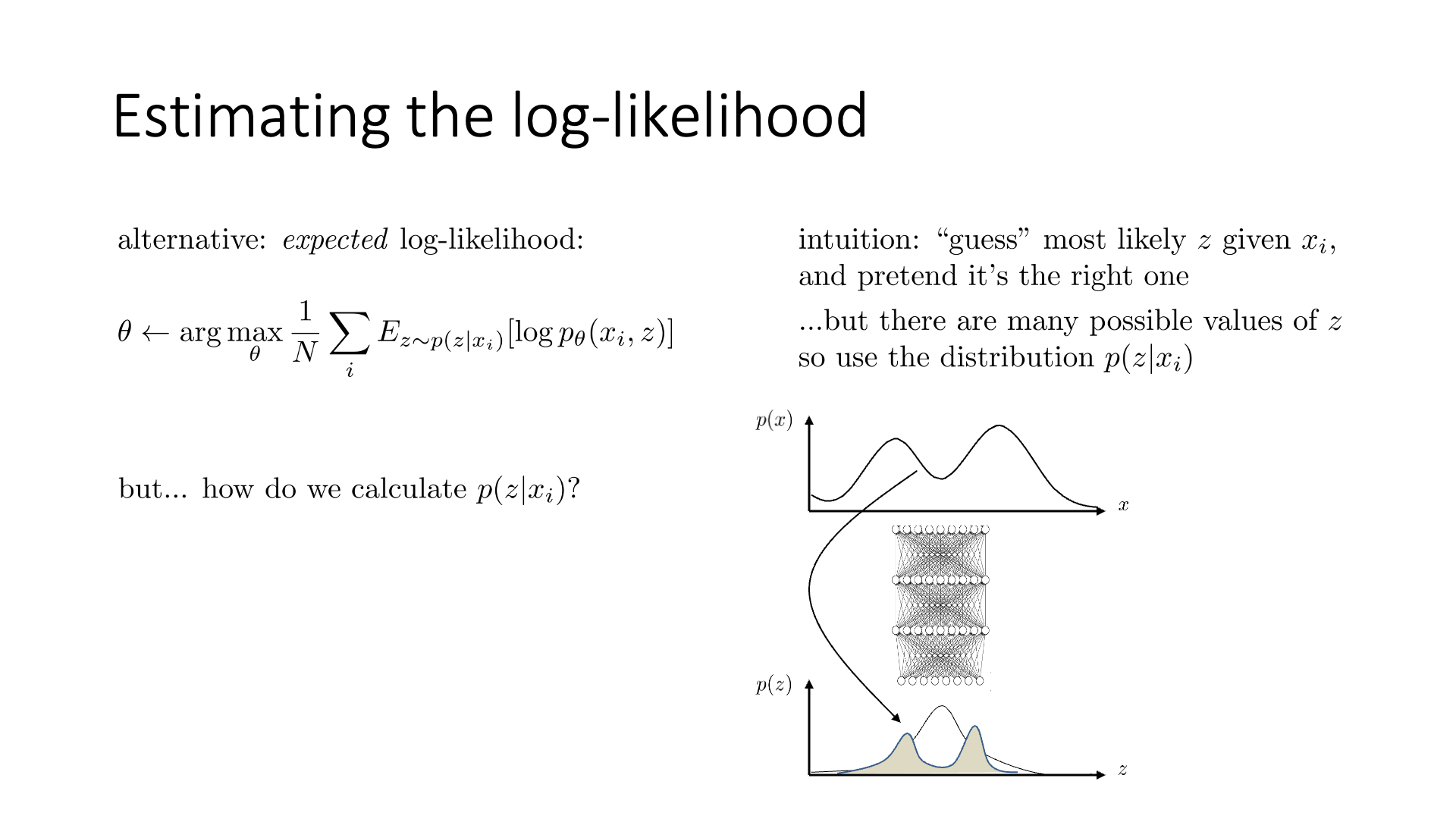

- LVM을 학습하려면 posterior라는 것을 계산해야하는데, commom deep learning setting에서는 이것이 불가능에 가깝다 (intractable)

- Variational inference가 이를 해결해줄 것이다.

- 이를 RL과 연관지어보자.

이제 LVM이 무엇인지부터 먼저 알아봅시다.

Probabilistic Latent Variable Models (LVM)

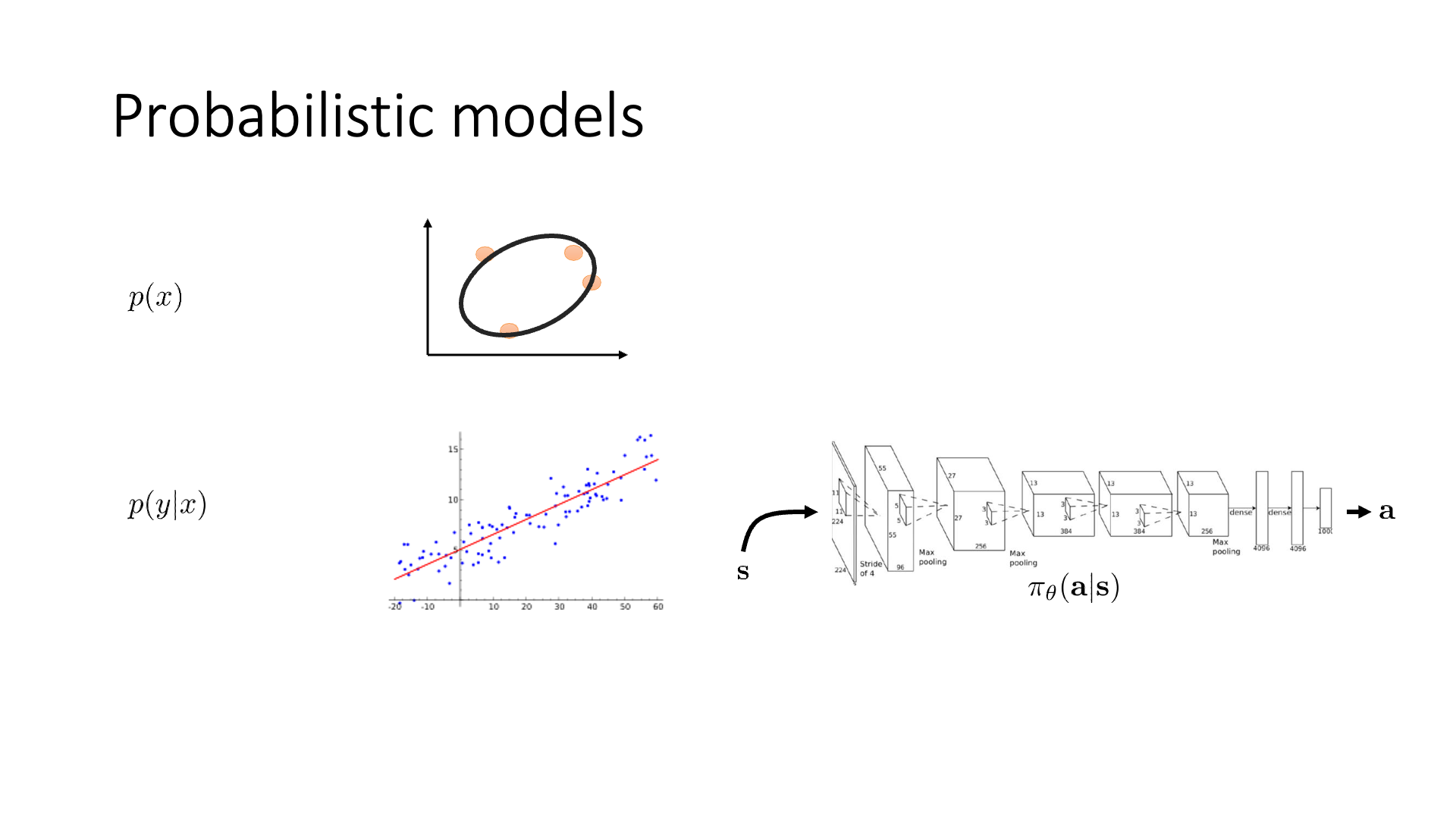

Slide. 3.

Slide. 3.

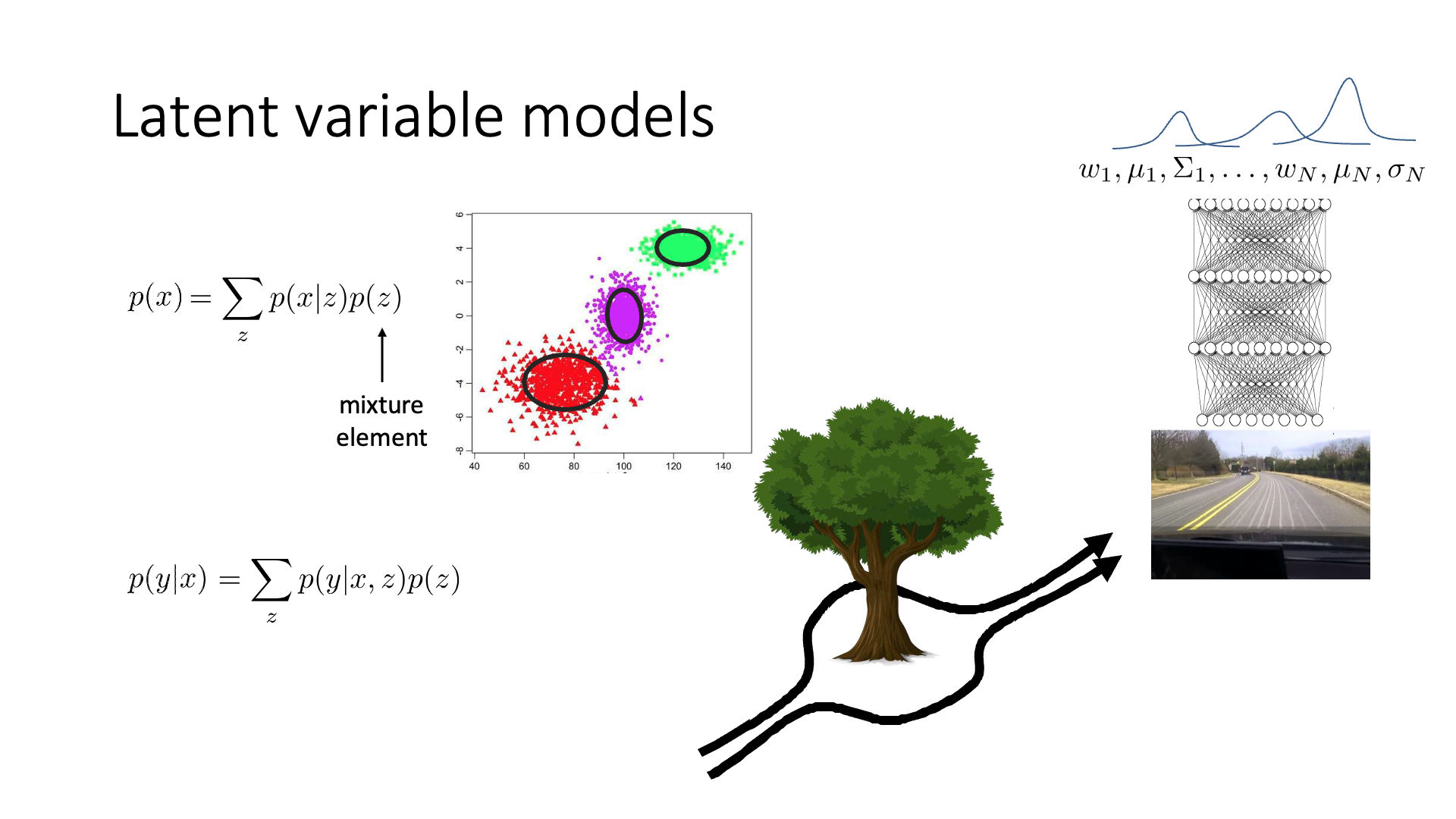

Slide. 4.

Slide. 4.

Slide. 5.

Slide. 5.

Slide. 6.

Slide. 6.

Slide. 7.

Slide. 7.

Slide. 9.

Slide. 9.

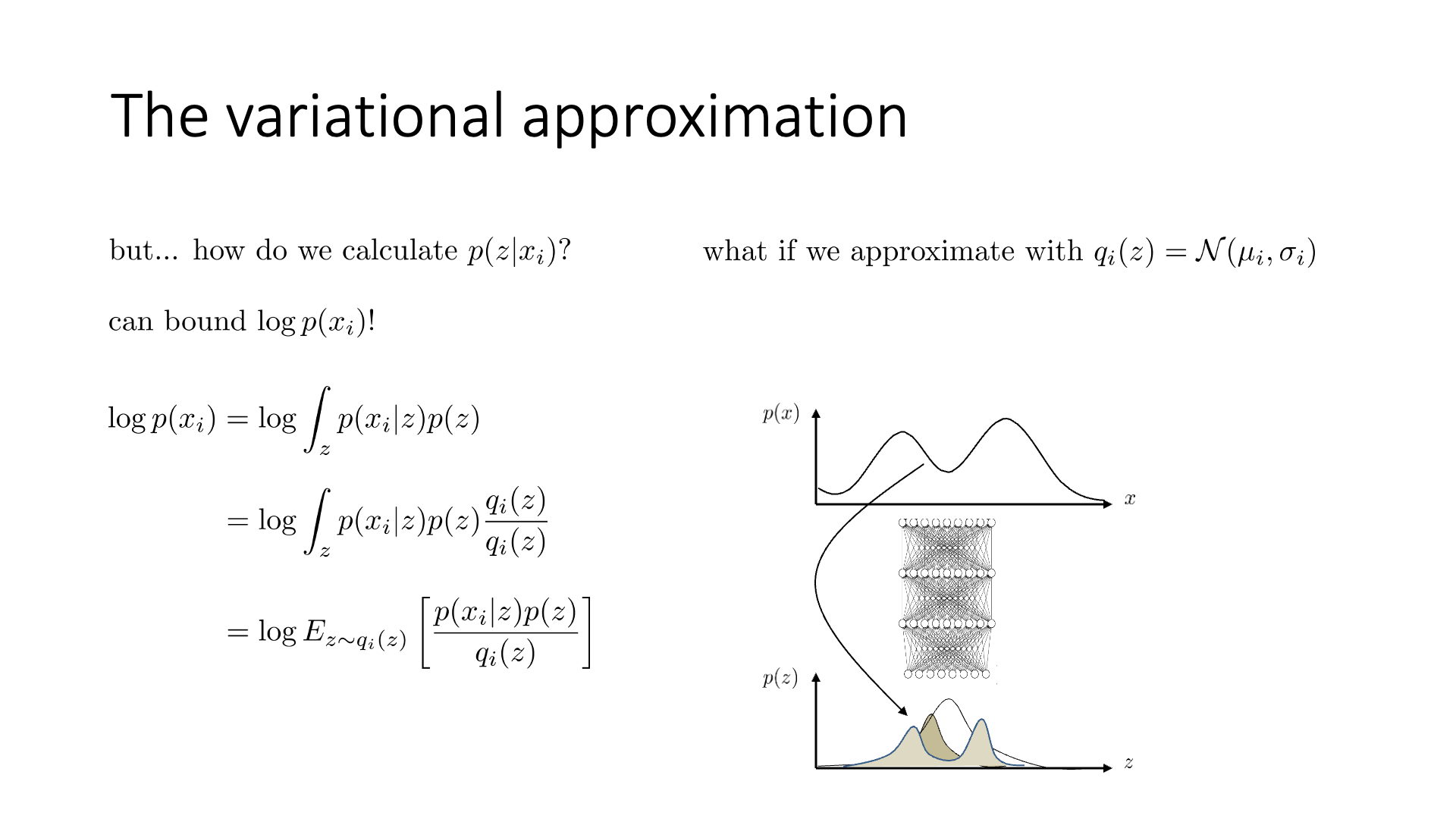

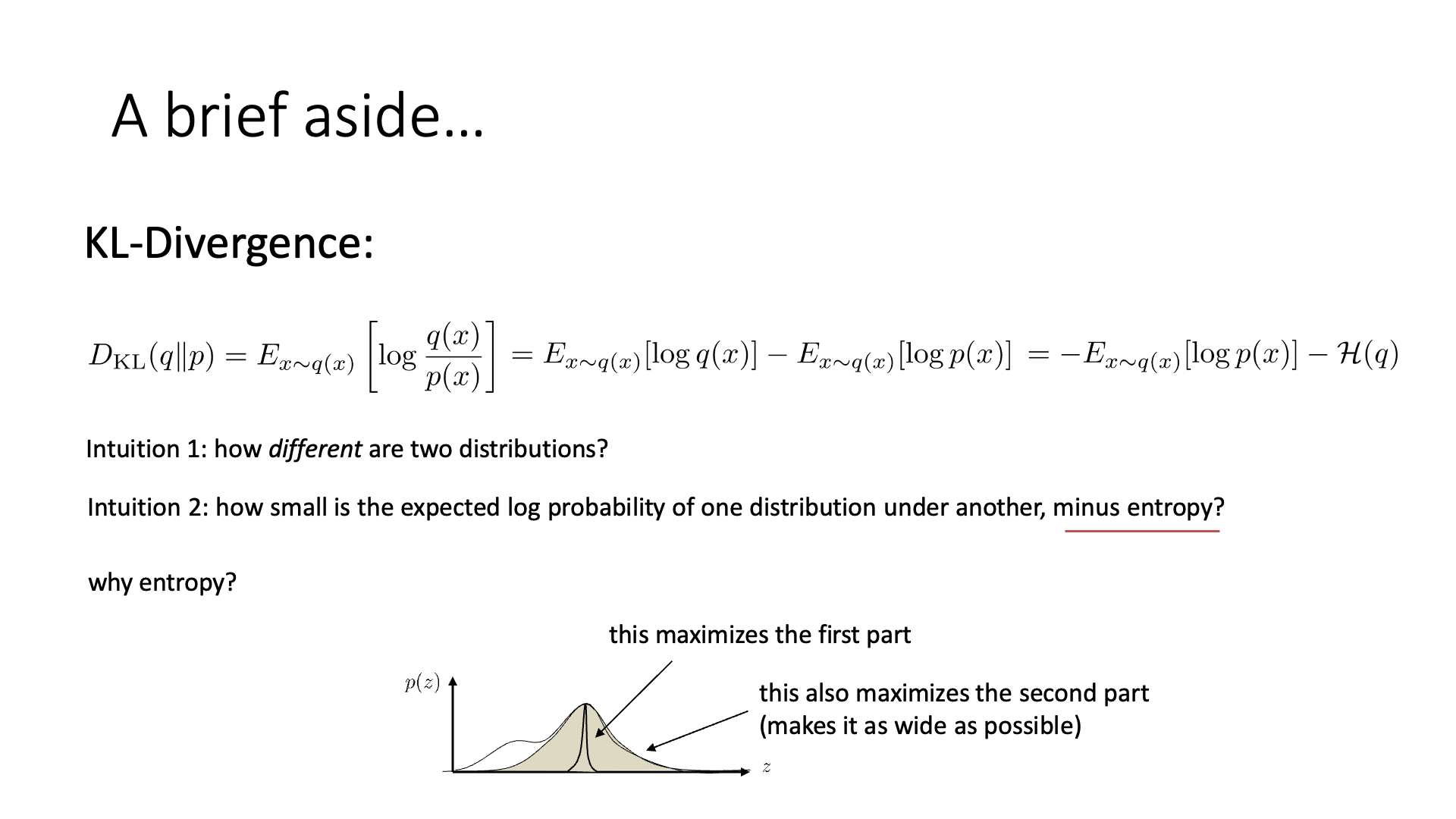

Variational Inference

Slide. 11.

Slide. 11.

Slide. 14.

Slide. 14.

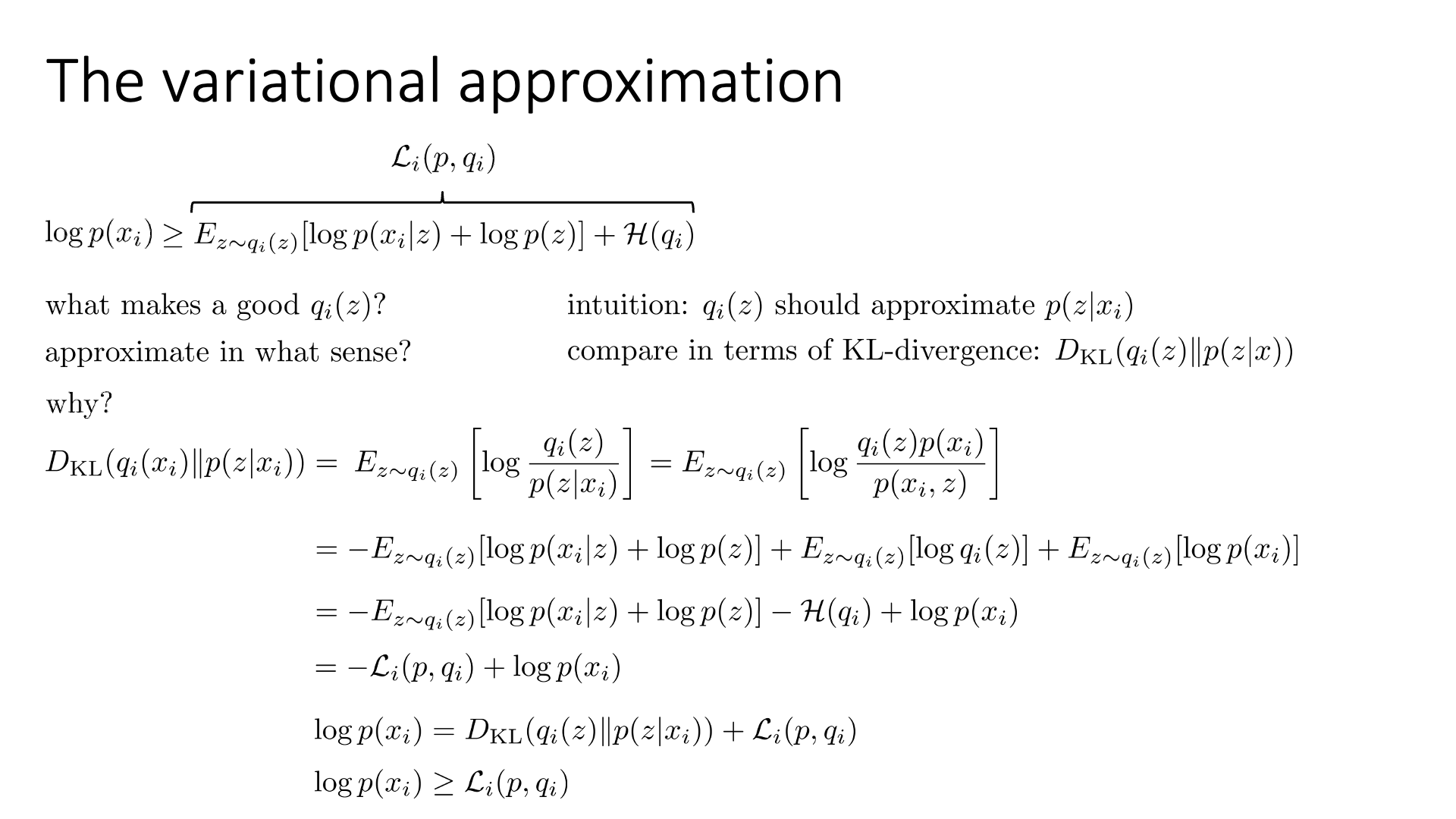

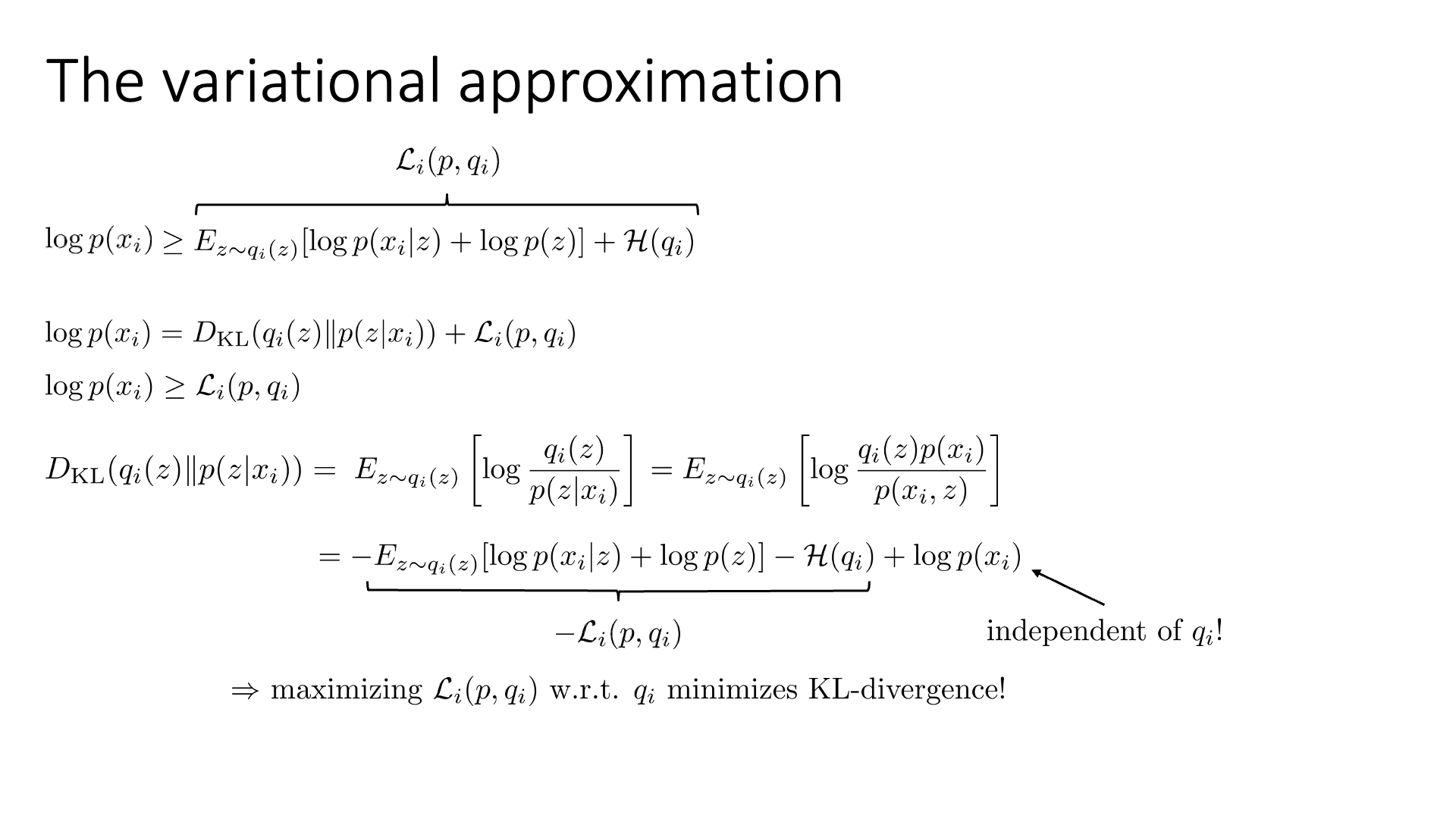

Slide. 15.

Slide. 15.

Slide. 16.

Slide. 16.

Slide. 17.

Slide. 17.

Slide. 18.

Slide. 18.

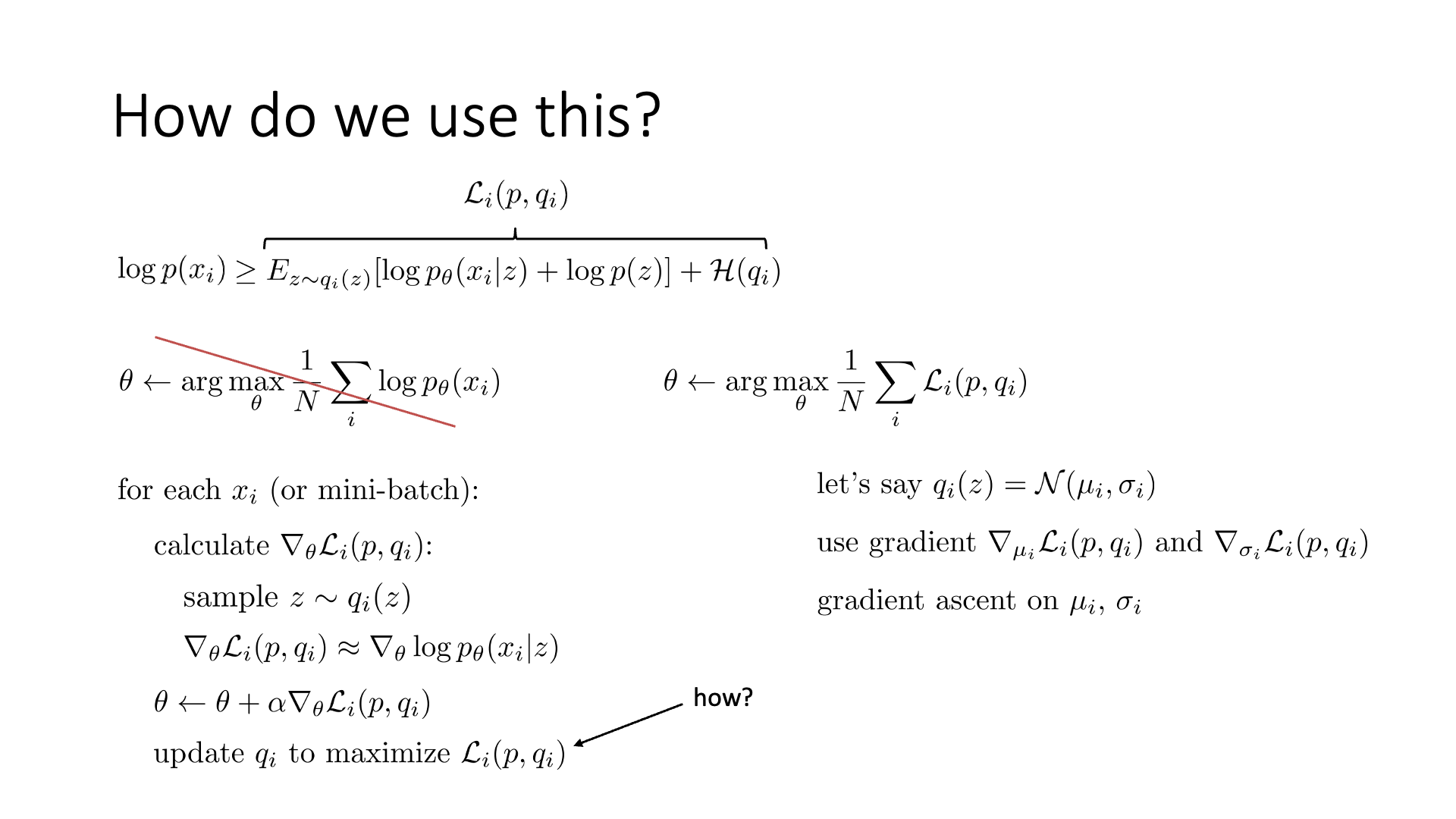

Amortized Variational Inference

Slide. 21.

Slide. 21.

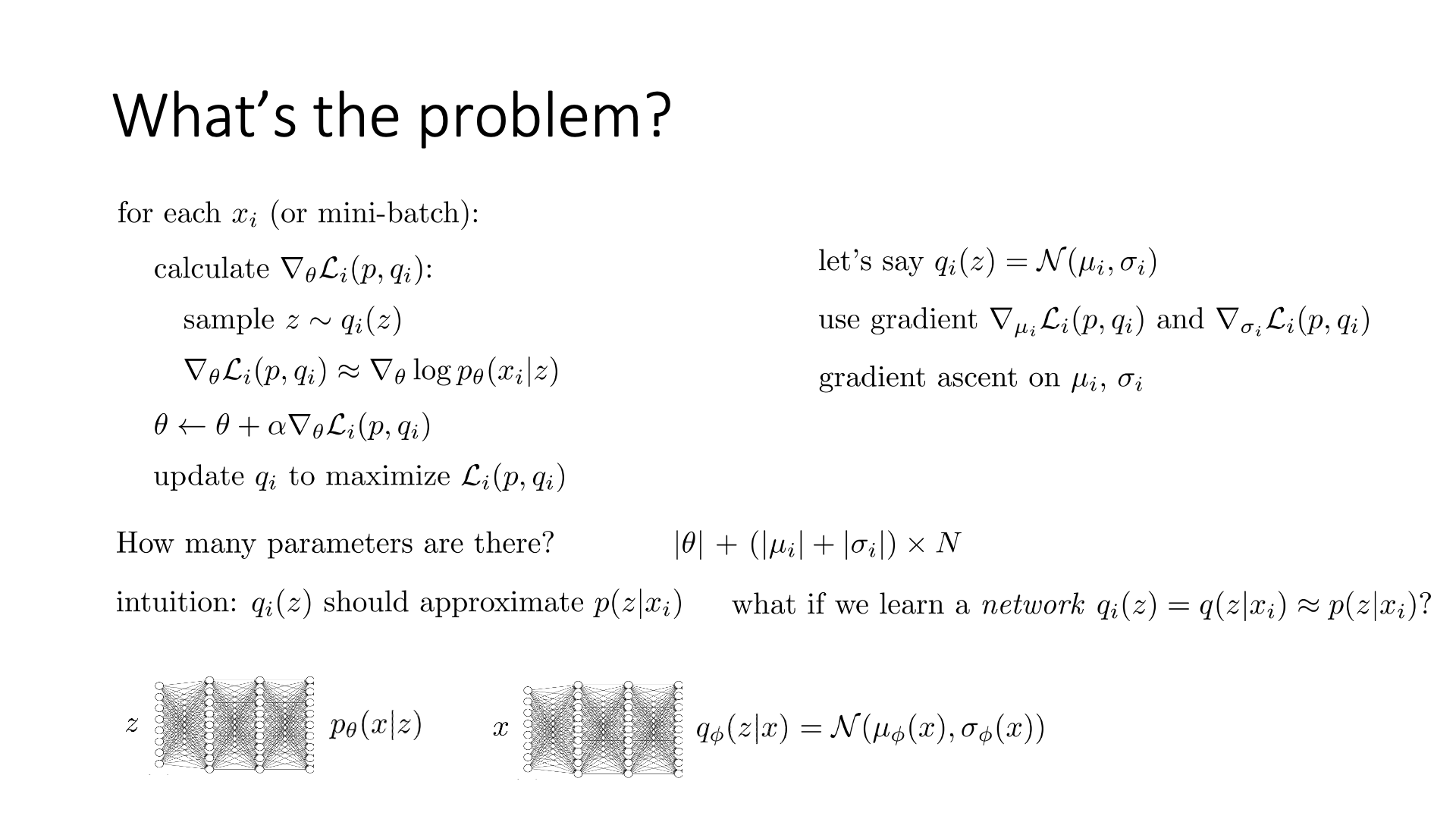

Slide. 22.

Slide. 22.

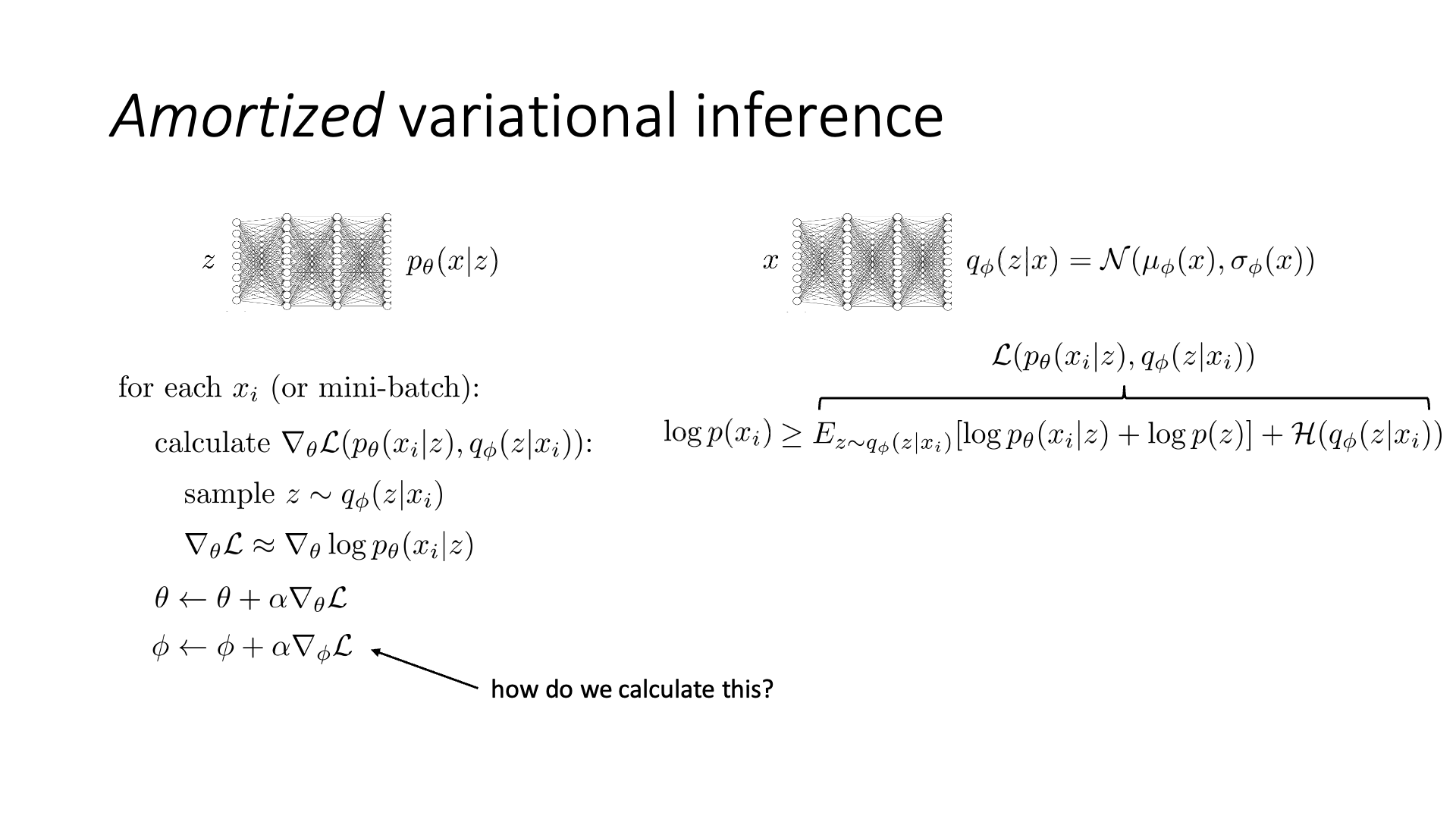

Slide. 23.

Slide. 23.

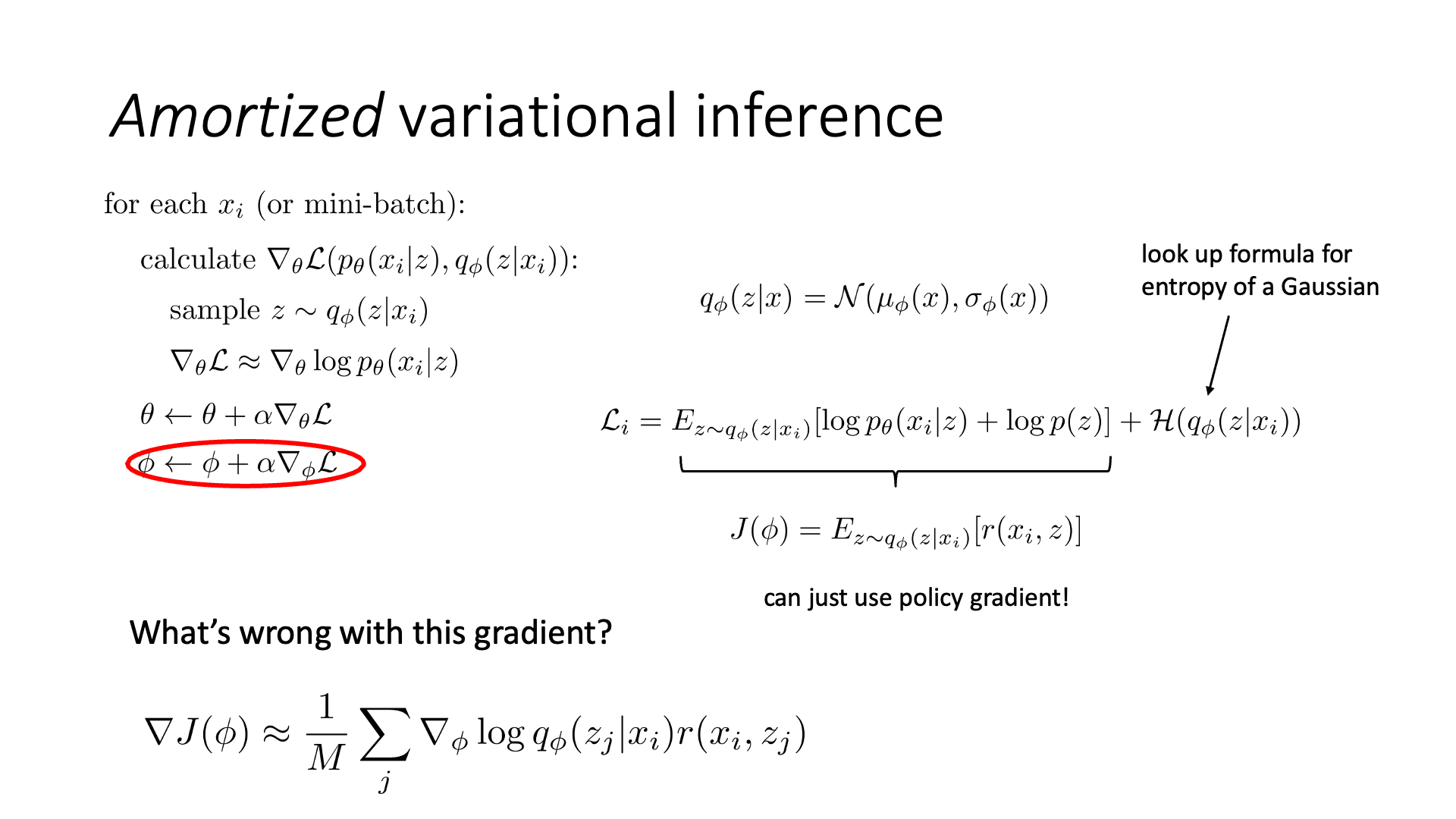

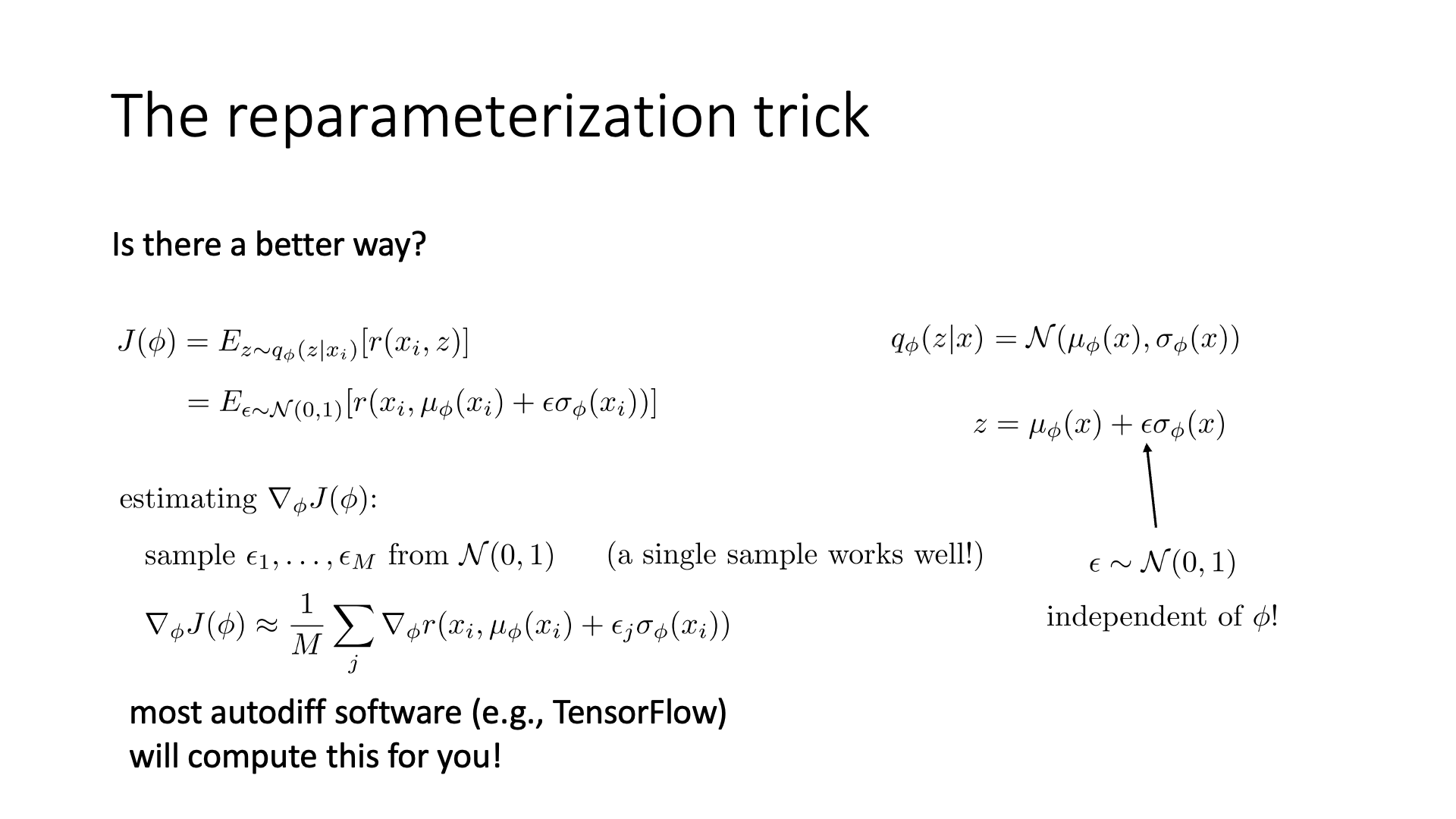

Slide. 24.

Slide. 24.

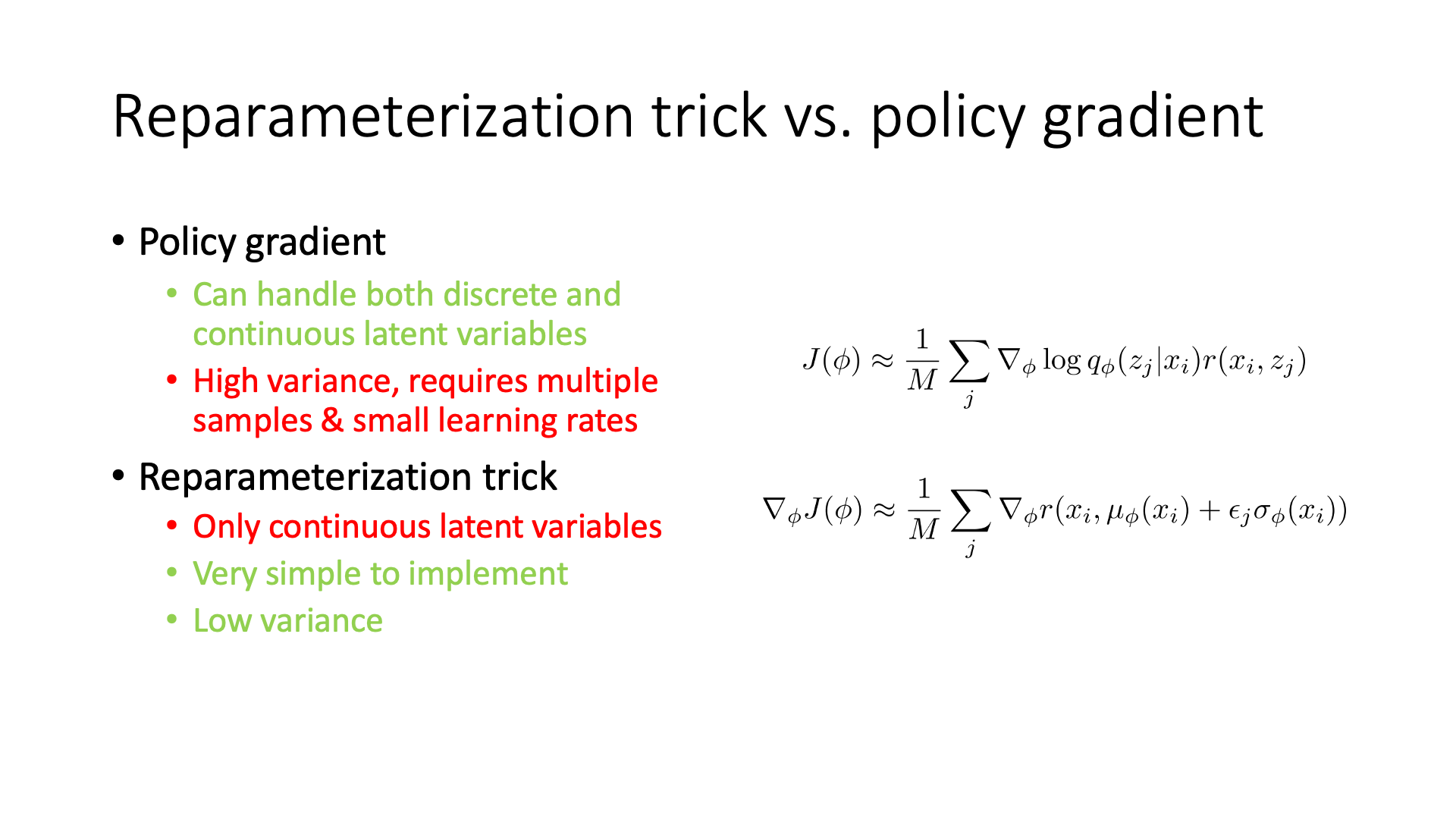

Slide. 25.

Slide. 25.

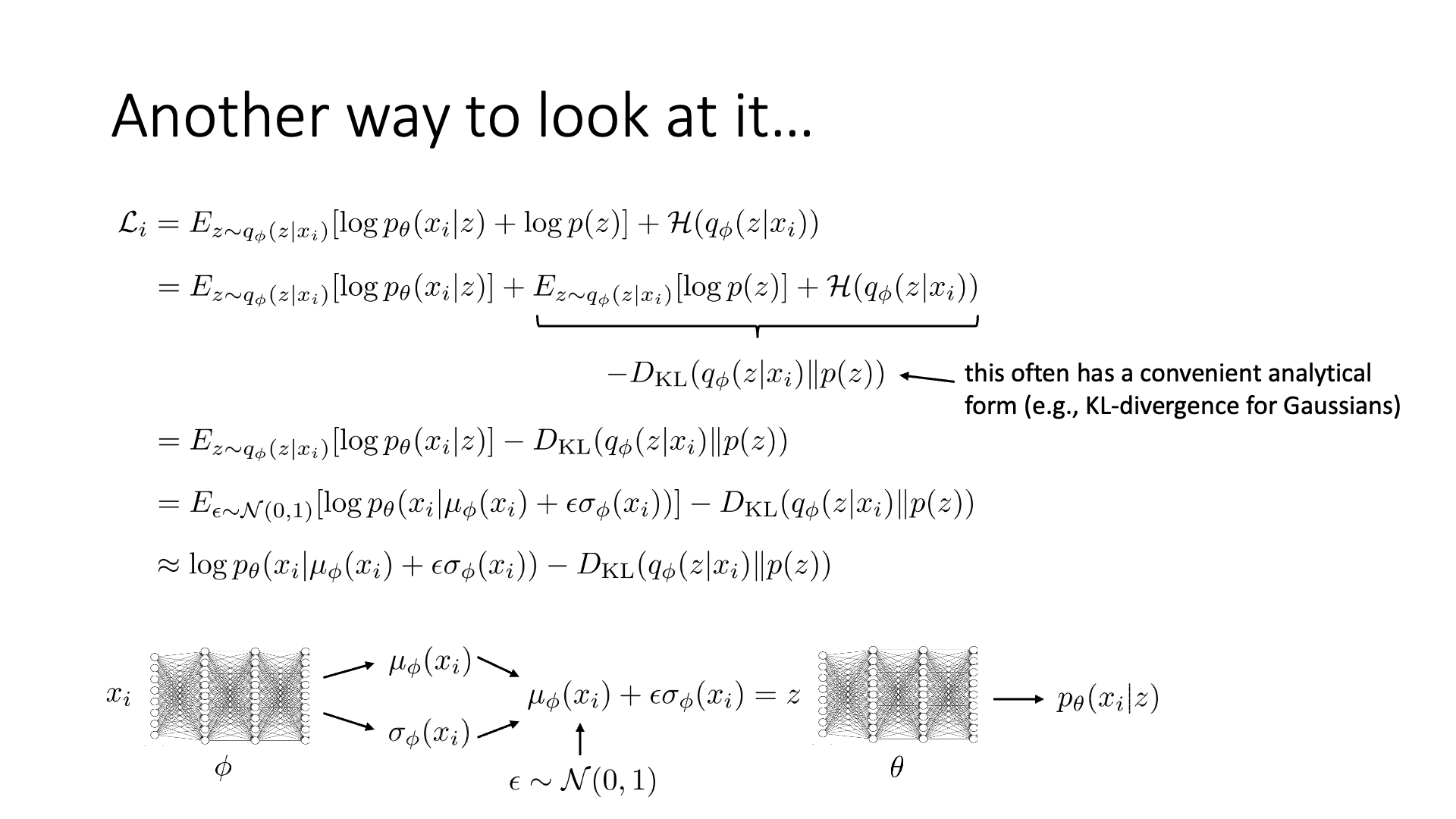

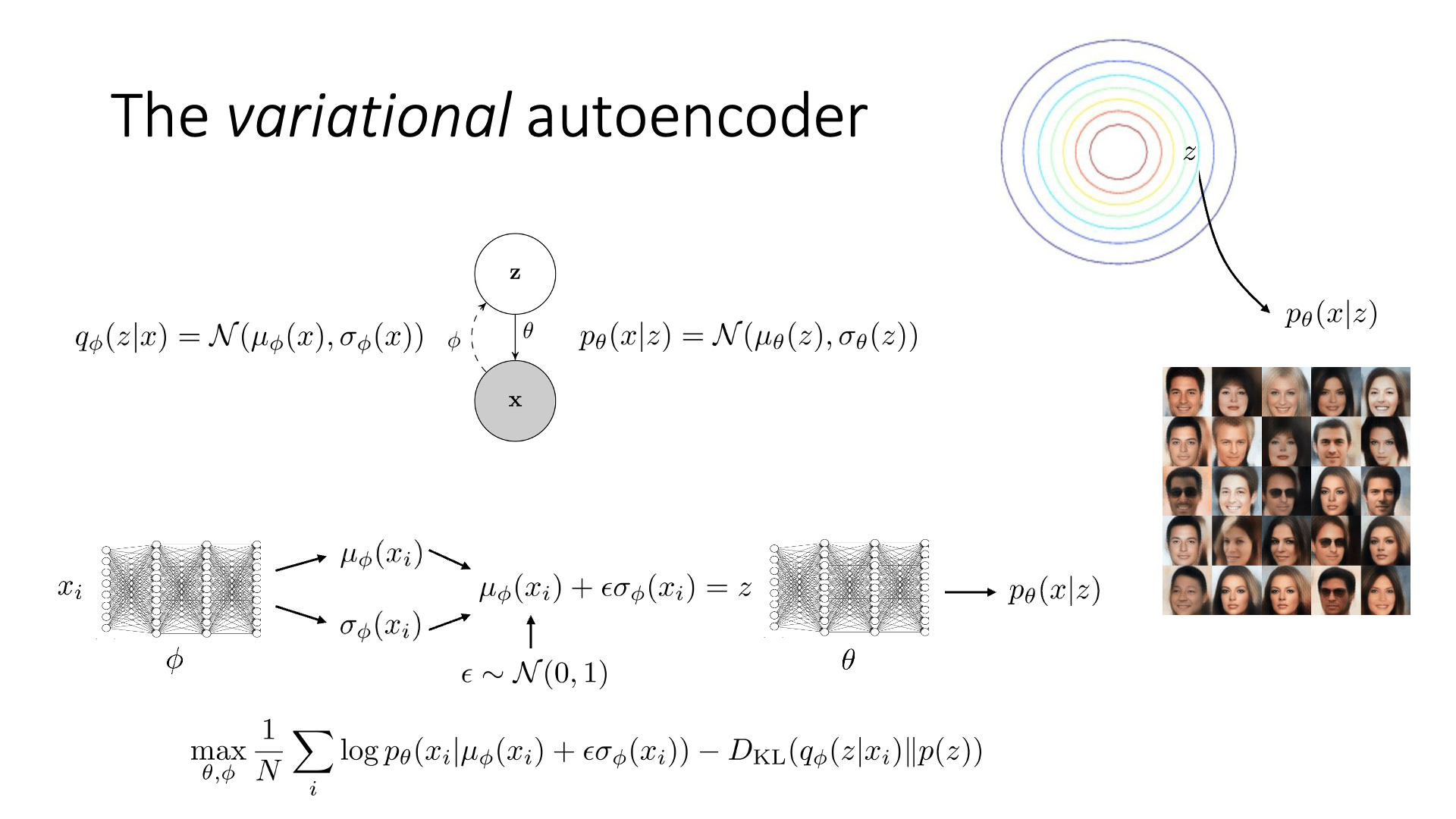

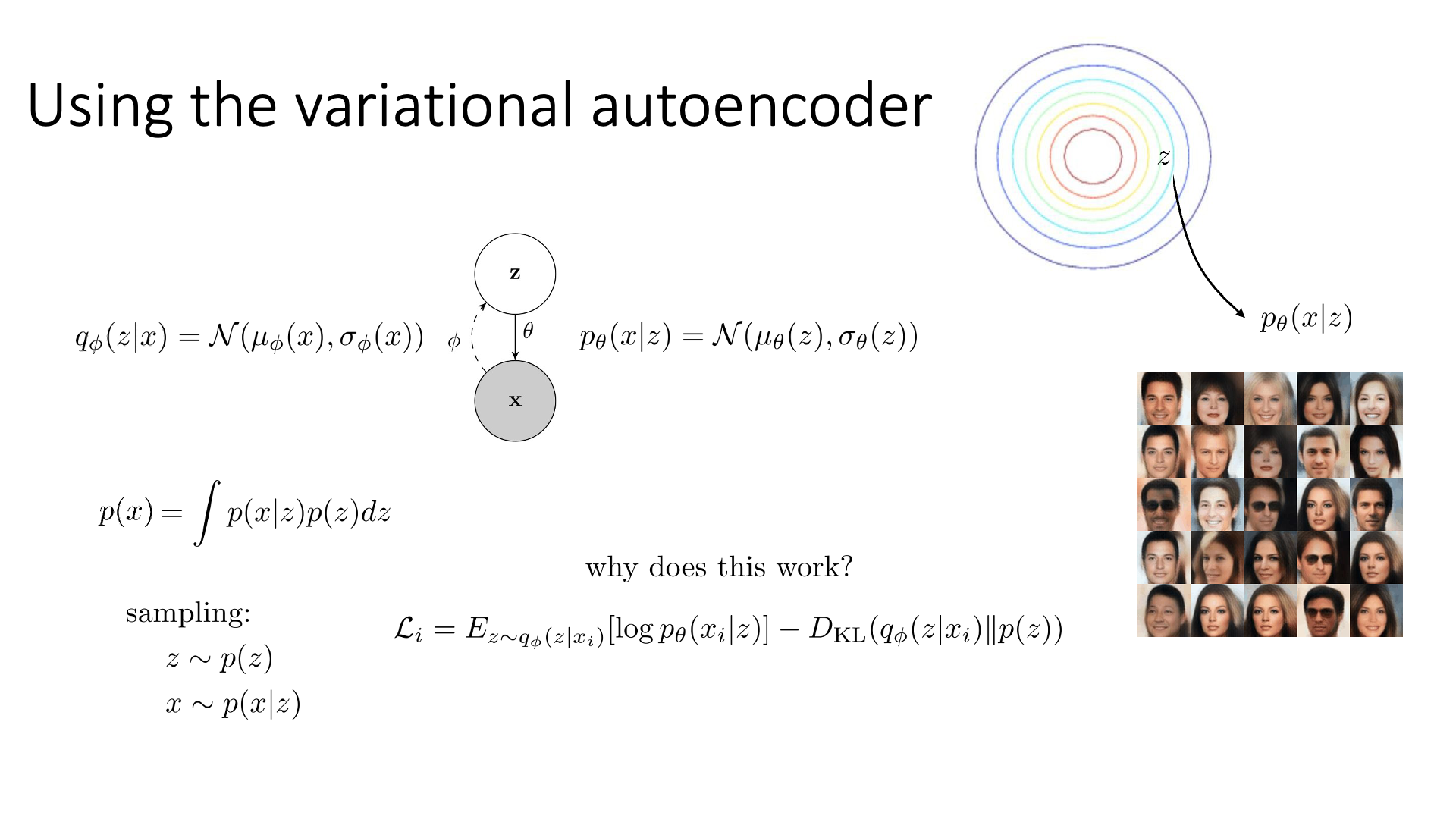

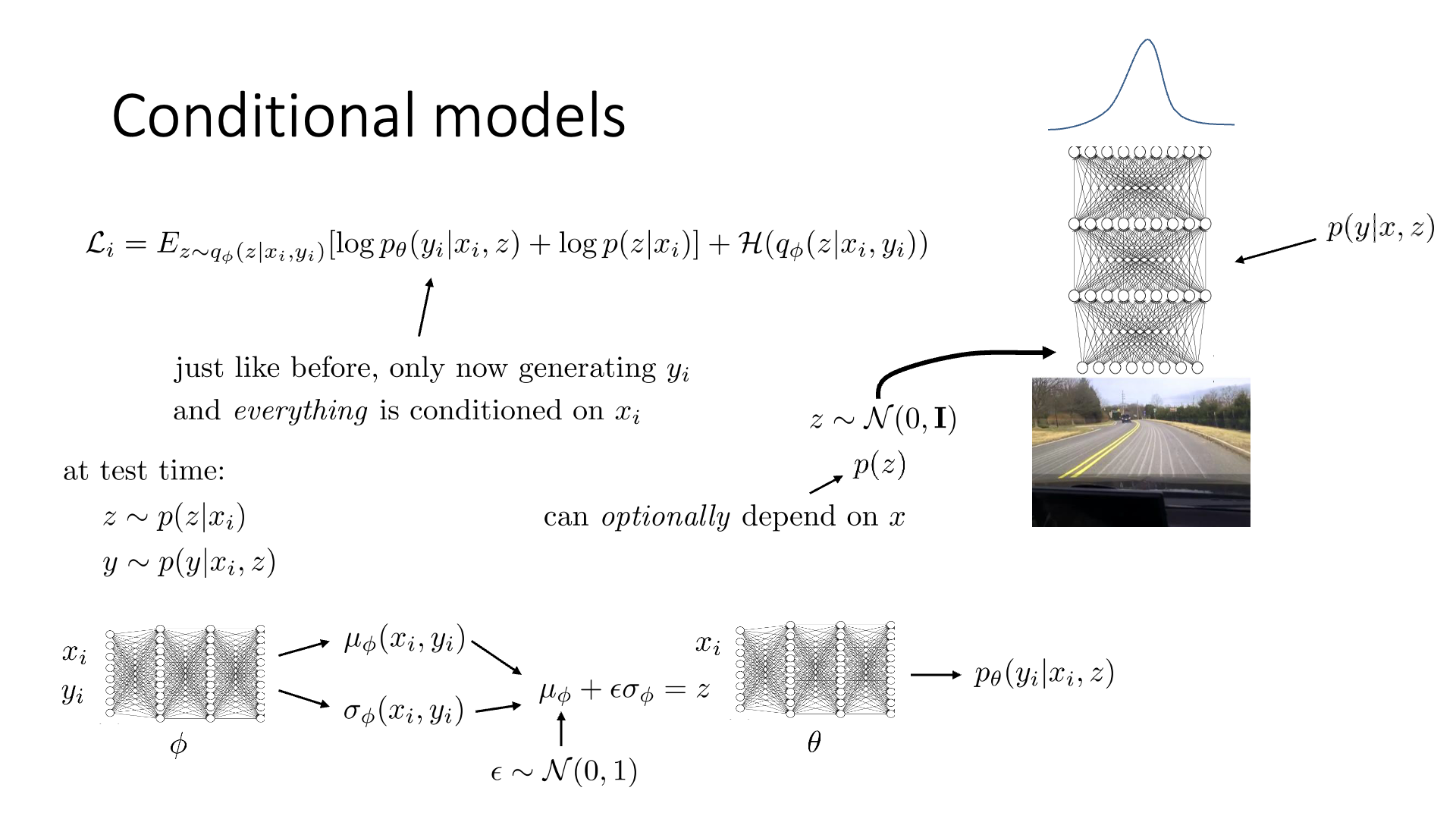

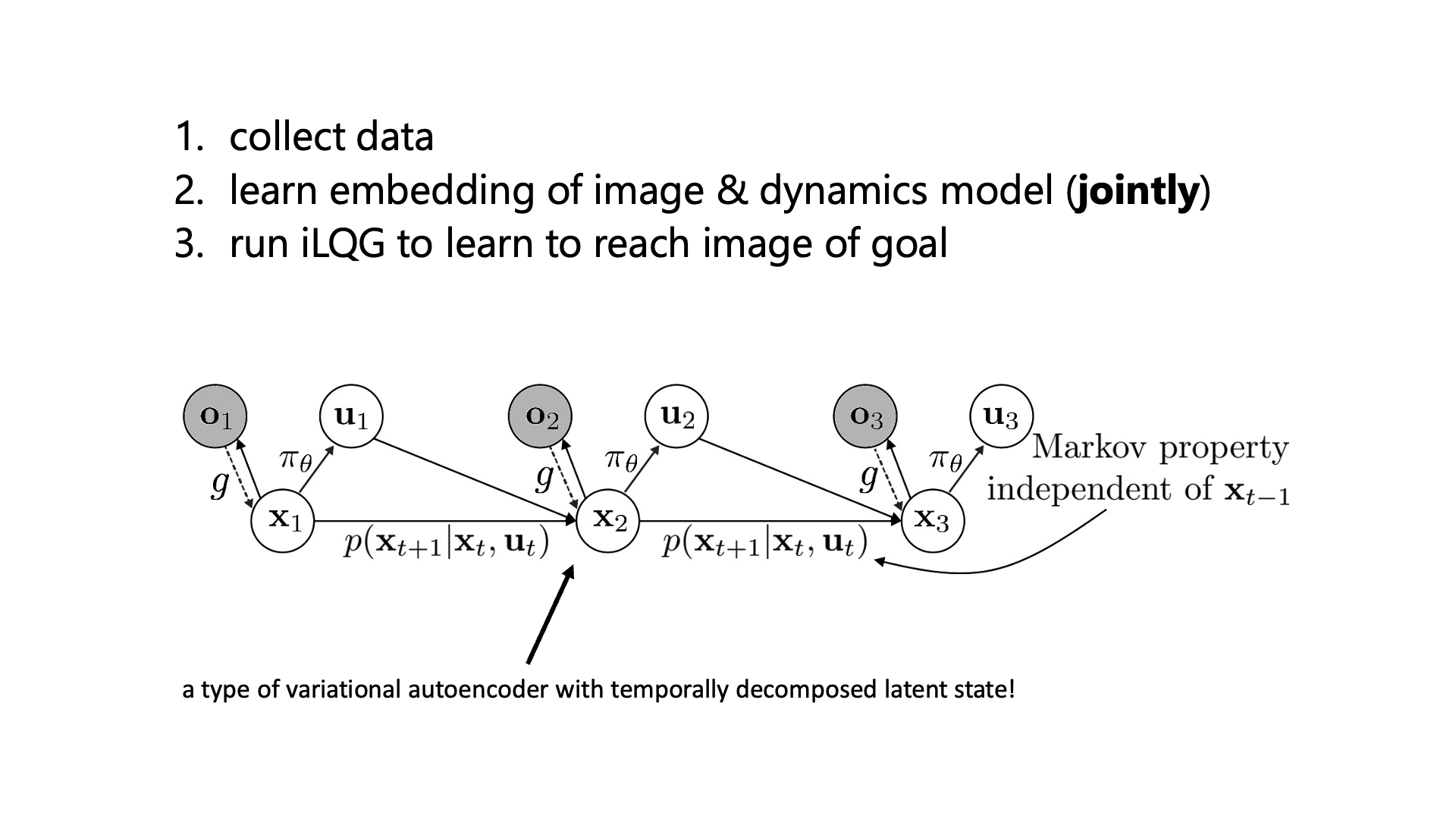

Generative models: Variational AutoEncoders (VAE)

Slide. 27.

Slide. 27.

Slide. 28.

Slide. 28.

Slide. 29.

Slide. 29.

Slide. 30.

Slide. 30.

Slide. 31.

Slide. 31.

Slide. 32.

Slide. 32.

Slide. 33.

Slide. 33.

Slide. 34.

Slide. 34.

asd

Reference

- Lecture Videos

- Others

- Papers and etc